Αποκτήστε τον Έλεγχο στις Α.Ι. Δημιουργίες σας!

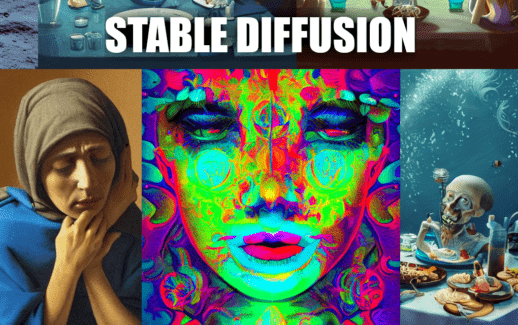

Οι Α.Ι. εφαρμογές που παράγουν εικόνες από κείμενο όπως το DALL-E, το Stable Diffusion, ή το MidJourney, μας έχουν προσφέρει πραγματικά εντυπωσιακές εικόνες τον τελευταίο καιρό!

Ο χρήστης μπορεί να καθοδηγήσει σε ένα βαθμό το αποτέλεσμα γράφοντας μία αναλυτική περιγραφή, όμως το τελικό αποτέλεσμα παραμένει αρκετά τυχαίο.

Ίσως ένας από τους μεγαλύτερους περιορισμούς αυτών των εφαρμογών, μέχρι τώρα, ήταν η απουσία του ελέγχου πάνω στην τελική εικόνα που θέλουμε να παράγουμε.

Όμως ήρθε η στιγμή να αλλάξει αυτό, με το ControlNet!

Μία πρόσφατη δημοσίευση παρουσίασε μία νέα ιδέα με σκοπό να αποκτήσουμε μεγαλύτερο έλεγχο στις text-to-image εφαρμογές! Το ControlNet είναι μία δομή νευρωνικών δικτύων που μπορεί να λειτουργήσει συνδυαστικά με ένα diffusion μοντέλο text-to-image και μας επιτρέπει παράλληλα με την περιγραφή κειμένου, να χρησιμοποιήσουμε και μία εικόνα αναφοράς, από την οποία μπορούμε να εξάγουμε κάποια βασικά χαρακτηριστικά που θα καθοδηγήσουν το τελικό αποτέλεσμα.

Αυτή η εικόνα για παράδειγμα δημιουργήθηκε χρησιμοποιώντας ένα σκίτσο για οδηγό και την περιγραφή “Α dog on the moon”.

Μπορείτε να δοκιμάσετε την εφαρμογή κατευθείαν από αυτή τη σελίδα:

Το μόνο που έχετε να κάνετε είναι:

- Να επιλέξετε τον τύπο της πληροφορίας που θέλετε να εξαχθεί από την εικόνα σας, επιλέγοντας το αντίστοιχο tab. Πχ: Canny / Scribble / Pose / Depth

- Να ανεβάσετε την εικόνα αναφοράς.

- Να γράψετε μία περιγραφή για την εικόνα που θέλετε να δημιουργήσετε (προαιρετικό)

- Να πατήσετε το κουμπί “Run”

Παραδείγματα

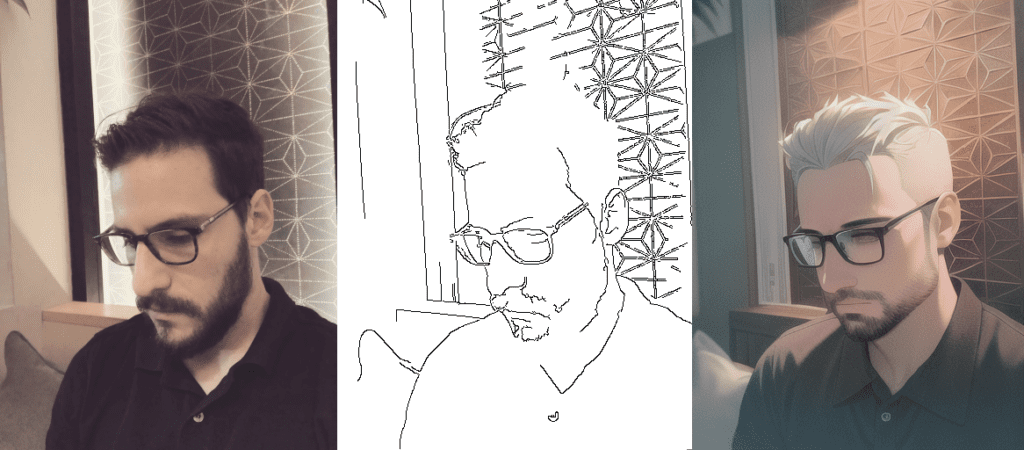

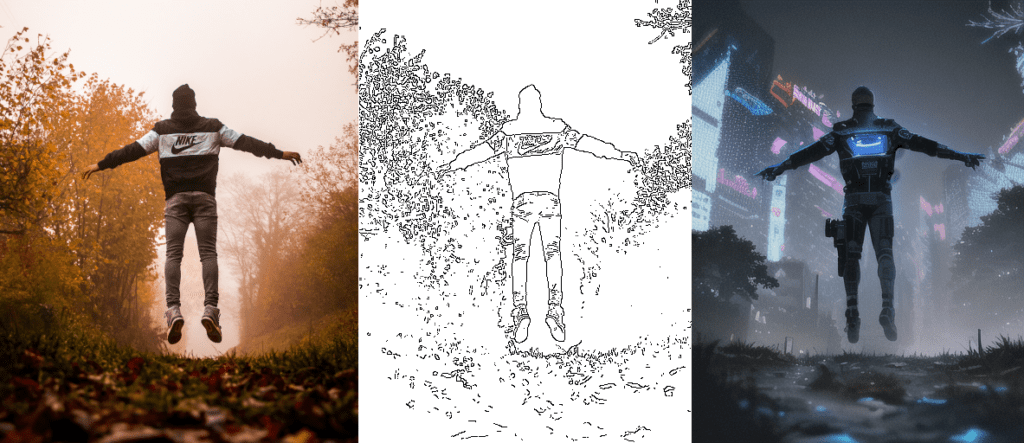

Παράδειγμα “Canny Edges” με περιγραφή “A man in a cyberpunk scene”

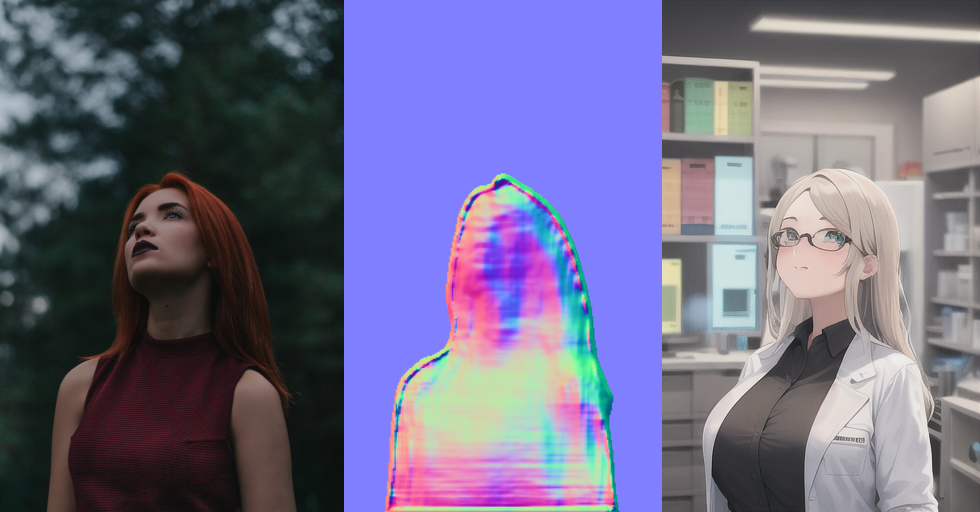

Παράδειγμα “Normal Map” με περιγραφή “An anime scientist girl in a laboratory”

Παράδειγμα “Depth Map” με περιγραφή “Ironman”

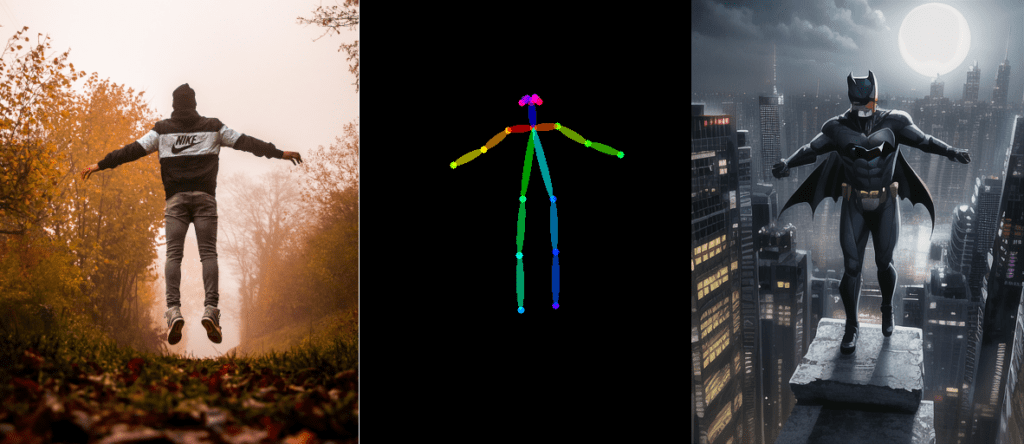

Παράδειγμα “Pose” με περιγραφή “Batman”

Μπορούμε επίσης να μην χρησιμοποιήσουμε καμία περιγραφή και η εφαμογή θα παράγει αυτόματα μία εικόνα που ακολουθεί τον οδηγό.

Παράδειγμα “Canny Edges” χωρίς περιγραφή.